使用情境

1. VS code + Llama coder

2. windows 11

安裝方式

1. 開啟VS code,到market搜尋Llama coder,並且安裝完畢。

Llama coder github: https://github.com/ex3ndr/llama-coder

2. Windows就需要安裝docker。安裝完畢後將docker啟動,並輸入以下指令來啟動ollama。

docker run -d --gpus=all -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollamaollama專案也是蠻有趣的,

官網: https://ollama.ai/

ollama github: https://github.com/jmorganca/ollama

ollama docker site: https://hub.docker.com/r/ollama/ollama (啟動ollama的方式在docker網頁比較多)

3. 重新開啟VS coder以後,底下應該有個圖示:

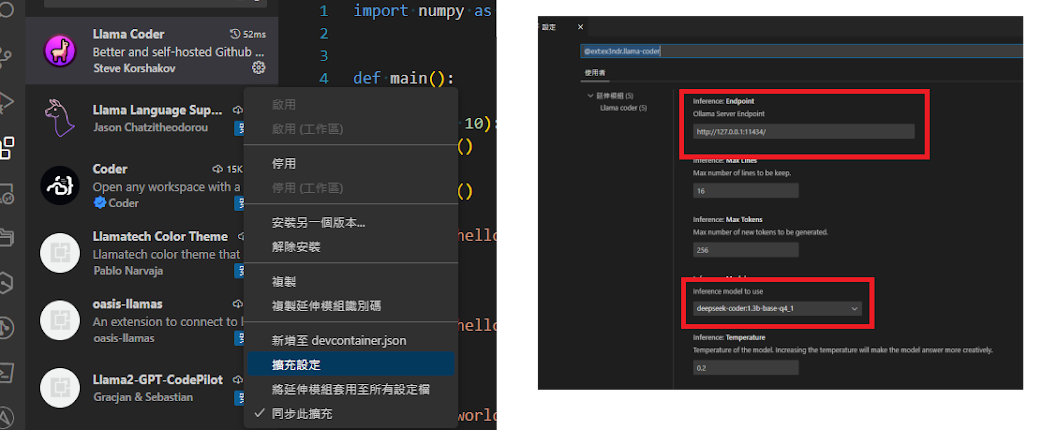

4. 使用VS code打開一個檔案。這時候Llama coder就會自動下載模型。如果想要更動模型或是有指定其他遠端的ollama機器也可以到Llma coder的設定區進行修改:

如果想看狀態,可以到vs code最底下的命令列,調閱"輸出"的tab,然後把窗格訂在Llama coder的位置上:

接下來每次寫code的時候,底下的Llama Coder應該都會一直轉,表示正在生成code。

理論上這個視窗不需要一直開著。整體看來,code的生成速度還是沒有whisper快速。

References:

https://github.com/ex3ndr/llama-coder/issues/3